Trong thời gian qua, các ông lớn công nghệ như OpenAI và Google đã liên tục ca ngợi khả năng “suy luận” vượt trội là bước tiến lớn tiếp theo trong các mô hình trí tuệ nhân tạo (AI) mới nhất của họ. Tuy nhiên, một nghiên cứu mới từ sáu kỹ sư của Apple đã chỉ ra rằng khả năng “suy luận” toán học được thể hiện bởi các mô hình ngôn ngữ lớn (LLM) tiên tiến có thể cực kỳ mong manh và không đáng tin cậy khi đối mặt với những thay đổi tưởng chừng như không đáng kể trong các bài toán chuẩn.

Điểm yếu được nêu bật trong những kết quả mới này củng cố cho các nghiên cứu trước đây, cho thấy rằng việc LLM sử dụng phương pháp đối sánh mẫu xác suất đang bỏ lỡ sự hiểu biết chính thức về các khái niệm cơ bản cần thiết cho khả năng suy luận toán học thực sự đáng tin cậy. “Các LLM hiện tại không có khả năng suy luận logic thực sự,” các nhà nghiên cứu đưa ra giả thuyết dựa trên những kết quả này. “Thay vào đó, chúng cố gắng sao chép các bước suy luận được quan sát thấy trong dữ liệu huấn luyện của chúng.”

Trong bài báo “GSM-Symbolic: Hiểu những hạn chế của Suy luận Toán học trong Mô hình Ngôn ngữ Lớn” – hiện có sẵn dưới dạng bản in trước – sáu nhà nghiên cứu của Apple bắt đầu với bộ dữ liệu tiêu chuẩn GSM8K gồm hơn 8.000 bài toán bằng lời văn ở cấp độ tiểu học, thường được sử dụng làm tiêu chuẩn đánh giá khả năng suy luận phức tạp của các LLM hiện đại. Sau đó, họ thực hiện phương pháp tiếp cận mới là sửa đổi một phần của bộ dữ liệu thử nghiệm đó để thay thế động một số tên và số bằng các giá trị mới – vì vậy, một câu hỏi về việc Sophie nhận được 31 khối xây dựng cho cháu trai của cô ấy trong GSM8K có thể trở thành một câu hỏi về việc Bill nhận được 19 khối xây dựng cho anh trai của anh ấy trong bài đánh giá GSM-Symbolic mới.

Phương pháp này giúp tránh bất kỳ “ô nhiễm dữ liệu” tiềm ẩn nào có thể xảy ra do các câu hỏi GSM8K tĩnh được đưa trực tiếp vào dữ liệu huấn luyện của mô hình AI. Đồng thời, những thay đổi ngẫu nhiên này không làm thay đổi độ khó thực sự của bản thân suy luận toán học, có nghĩa là về mặt lý thuyết, các mô hình sẽ hoạt động tốt như nhau khi được thử nghiệm trên GSM-Symbolic như GSM8K.

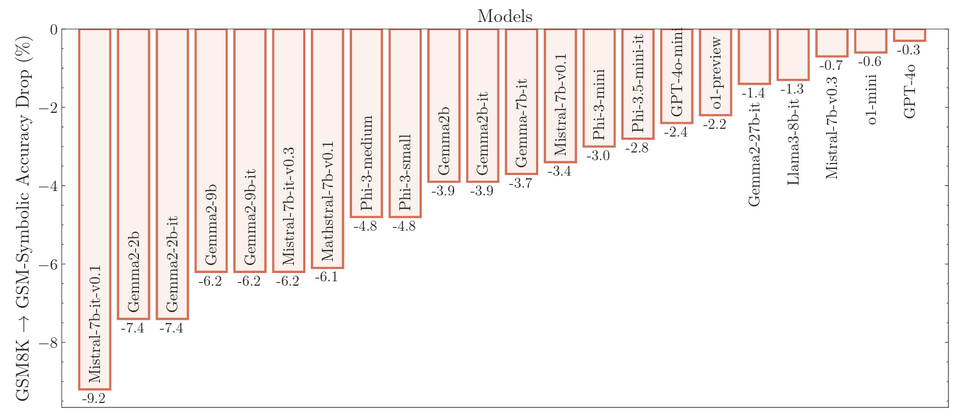

Tuy nhiên, khi các nhà nghiên cứu thử nghiệm hơn 20 LLM hiện đại trên GSM-Symbolic, họ nhận thấy độ chính xác trung bình giảm trên diện rộng so với GSM8K, với mức giảm hiệu suất từ 0,3% đến 9,2%, tùy thuộc vào mô hình. Kết quả cũng cho thấy phương sai cao trên 50 lần chạy riêng biệt của GSM-Symbolic với các tên và giá trị khác nhau. Khoảng cách lên đến 15% độ chính xác giữa các lần chạy tốt nhất và kém nhất là phổ biến trong một mô hình duy nhất và vì một số lý do, việc thay đổi số có xu hướng dẫn đến độ chính xác kém hơn so với việc thay đổi tên.

Loại phương sai này – cả trong các lần chạy GSM-Symbolic khác nhau và so với kết quả GSM8K – gây ngạc nhiên hơn một chút vì, như các nhà nghiên cứu chỉ ra, “các bước suy luận tổng thể cần thiết để giải quyết một câu hỏi vẫn giữ nguyên.” Việc những thay đổi nhỏ như vậy dẫn đến kết quả biến đổi như vậy cho thấy các mô hình này không thực hiện bất kỳ suy luận “chính thức” nào mà thay vào đó là “cố gắng thực hiện một loại đối sánh mẫu trong phân phối, căn chỉnh các câu hỏi và bước giải pháp đã cho với những câu hỏi tương tự được thấy trong dữ liệu huấn luyện.”

Kết quả của bài báo GSM-Symbolic mới này không hoàn toàn mới trong thế giới nghiên cứu AI. Các bài báo gần đây khác cũng chỉ ra rằng LLM không thực sự thực hiện suy luận chính thức mà thay vào đó là bắt chước nó bằng cách đối sánh mẫu xác suất của dữ liệu tương tự gần nhất được thấy trong bộ dữ liệu huấn luyện khổng lồ của chúng.

Tuy nhiên, nghiên cứu mới làm nổi bật mức độ mong manh của loại bắt chước này khi lời nhắc trong câu hỏi đẩy nó theo hướng không chính xác khớp với bất kỳ dữ liệu huấn luyện nào. Nó cũng làm nổi bật những hạn chế cố hữu trong việc cố gắng thực hiện suy luận cấp cao mà không có bất kỳ mô hình cơ bản nào về logic hoặc thế giới đằng sau nó. Như Benj Edwards của Ars đã viết trong một câu chuyện vào tháng 7 về tạo video AI:

“Chúng ta có thể đang chứng kiến một “ảo tưởng về sự hiểu biết” tương tự với các mô hình “suy luận” mới nhất của AI và chứng kiến cách ảo tưởng đó có thể bị phá vỡ khi mô hình chạy vào những tình huống không mong muốn.”

Chuyên gia AI Gary Marcus, trong bài phân tích của mình về bài báo GSM-Symbolic mới, lập luận rằng bước nhảy vọt lớn tiếp theo trong khả năng của AI sẽ chỉ đến khi các mạng nơ-ron này có thể tích hợp “thao tác ký hiệu thực sự, trong đó một số kiến thức được thể hiện một cách trừu tượng theo các biến và hoạt động trên các biến đó, giống như những gì chúng ta thấy trong đại số và lập trình máy tính truyền thống…” Cho đến lúc đó, chúng ta sẽ nhận được kiểu “suy luận” mong manh có thể khiến các mô hình AI thất bại trong các bài kiểm tra toán học theo những cách mà máy tính bỏ túi không bao giờ làm được.

Tuyên bố miễn trừ trách nhiệm: Thông tin được cung cấp chỉ mang tính chất thông tin chung, https://lacongnghe.com không đưa ra bất kỳ tuyên bố hoặc bảo đảm nào liên quan đến thông tin, bao gồm nhưng không giới hạn bất kỳ sự tuyên bố hoặc bảo đảm về tính thích hợp cho bất kỳ mục đích cụ thể nào của thông tin theo phạm vi cho phép tối đa của pháp luật. Mặc dù đã nỗ lực để đảm bảo rằng thông tin được cung cấp trong bài viết này là chính xác, đáng tin cậy và hoàn chỉnh vào thời điểm đăng tải, nhưng thông tin được cung cấp trong bài viết này không nên được dựa vào để đưa ra bất kỳ quyết định tài chính, đầu tư, bất động sản, giao dịch hoặc pháp lý nào. Thêm vào đó, thông tin không thể thay thế lời khuyên từ một chuyên gia được đào tạo, người mà có thể xem xét, đánh giá các sự kiện và hoàn cảnh cá nhân của bạn, và chúng tôi không chịu bất kỳ trách nhiệm nào nếu bạn sử dụng những thông tin này để đưa ra quyết định. Xin cảm ơn!